Databricks vs Snowflake: Una Comparación Integral para Analistas de Datos y Científicos de Datos

Updated on

A medida que los datos continúan creciendo en importancia y complejidad, los analistas y científicos de datos necesitan aprovechar las herramientas más adecuadas para obtener ideas valiosas. En esta comparación integral, exploraremos dos de las plataformas de datos más populares: Databricks y Snowflake. Examinaremos sus características, ventajas y desventajas para ayudarte a tomar una decisión informada sobre la herramienta adecuada para tus necesidades. Además, incluiremos enlaces internos relevantes para proporcionar recursos adicionales y contexto.

Resumen

Databricks (opens in a new tab) es una plataforma basada en la nube que proporciona un espacio de trabajo unificado de análisis para el procesamiento de grandes volúmenes de datos, aprendizaje automático y aplicaciones de inteligencia artificial. Está construido sobre el popular marco Apache Spark, lo que permite a los usuarios escalar sus tareas de procesamiento y análisis de datos de manera eficiente.

Snowflake (opens in a new tab), por otro lado, es una solución de almacén de datos basada en la nube que se enfoca en el almacenamiento, gestión y análisis de datos estructurados y semiestructurados. Está diseñado para admitir el procesamiento masivo paralelo (MPP), lo que permite consultas y análisis rápidos de datos.

Características Clave

Databricks

- Plataforma de Análisis Unificado: Databricks combina la ingeniería de datos, la ciencia de datos y la inteligencia artificial en una plataforma, lo que permite la colaboración entre diferentes equipos y roles.

- Apache Spark: Como plataforma basada en Spark, Databricks ofrece un alto rendimiento y escalabilidad para el procesamiento de grandes volúmenes de datos y cargas de trabajo de aprendizaje automático.

- Espacio de Trabajo Interactivo: Databricks proporciona un espacio de trabajo interactivo con soporte para varios lenguajes, como Python, R, Scala y SQL. También cuenta con integración integrada con Jupyter Notebook (opens in a new tab).

- MLflow: Databricks incluye MLflow, una plataforma de código abierto para la gestión del ciclo de vida completo del aprendizaje automático, lo que simplifica el desarrollo y la implementación de modelos.

- Delta Lake: Delta Lake es una capa de almacenamiento de código abierto que aporta transacciones ACID y otras características de confiabilidad de datos a su lago de datos, mejorando la calidad y consistencia de los datos.

Snowflake

- Almacén de Datos en la Nube: El enfoque principal de Snowflake es proporcionar una solución escalable y fácil de usar de almacén de datos en la nube.

- Arquitectura Única: La arquitectura de Snowflake separa el almacenamiento, el procesamiento y los servicios en la nube, lo que permite una escalabilidad y optimización de costos independientes.

- Soporte para Datos Estructurados y Semiestructurados: Snowflake puede manejar datos estructurados y semiestructurados, como JSON, Avro, Parquet y XML.

- Compartir e Integrar Datos: Snowflake ofrece capacidades de intercambio de datos nativas, lo que simplifica la colaboración de datos entre organizaciones. También proporciona una amplia gama de herramientas de integración de datos (opens in a new tab) para agilizar la ingesta y el procesamiento de datos.

- Seguridad y Cumplimiento: Snowflake pone un fuerte énfasis en la seguridad y el cumplimiento, con características como cifrado, control de acceso basado en roles y soporte para diversos estándares de cumplimiento.

Comparación de Rendimiento, Escalabilidad y Costos

Rendimiento

Databricks, al estar construido sobre Apache Spark, está optimizado para el procesamiento de datos de alto rendimiento y tareas de aprendizaje automático. En comparación, el enfoque de Snowflake en el almacenamiento de datos se traduce en una ejecución rápida de consultas y análisis. Sin embargo, cuando se trata de cargas de trabajo de aprendizaje automático e inteligencia artificial, Databricks tiene una clara ventaja.

Escalabilidad

Tanto Databricks como Snowflake están diseñados para escalar según las necesidades de tus datos. Databricks aprovecha las capacidades de Spark para manejar el procesamiento de grandes volúmenes de datos, mientras que la arquitectura única de Snowflake permite escalar de forma independiente los recursos de almacenamiento y procesamiento. Esta flexibilidad permite a las organizaciones adaptar su infraestructura según sus requisitos específicos y limitaciones presupuestarias.

Costos

Databricks y Snowflake ofrecen modelos de precios de pago por uso, lo que significa que solo pagas por los recursos que consumes. Sin embargo, sus estructuras de precios difieren en algunos aspectos clave. Databricks cobra en función de las instancias de máquinas virtuales, el almacenamiento de datos y la transferencia de datos, mientras que los precios de Snowflake se determinan por el volumen de datos almacenados, el número de recursos de procesamiento (también conocidos como "almacenes") y la cantidad de datos ingresados.

Es importante evaluar cuidadosamente las necesidades de procesamiento y almacenamiento de datos de tu organización para determinar qué plataforma ofrece la solución más rentable. Ten en cuenta que la optimización de costos a menudo depende de una gestión eficiente de recursos y de aprovechar características como el escalado automático y la pausa automática.

Integración y Ecosistema

Tanto Databricks como Snowflake ofrecen amplias opciones de integración con fuentes de datos, herramientas y plataformas populares.

-

Databricks se integra perfectamente con herramientas de procesamiento de grandes volúmenes de datos como Hadoop, así como con servicios de almacenamiento de datos como Amazon S3, Azure Blob Storage y Google Cloud Storage. Además, admite herramientas populares de visualización de datos como Tableau y Power BI.

-

Snowflake, al ser una solución de almacén de datos, ofrece numerosos conectores y opciones de integración para la ingesta de datos y los procesos de ETL, incluidas herramientas populares como Fivetran, Matillion y Talend. También admite la integración con plataformas de inteligencia empresarial como Looker, Tableau y Power BI.

En cuanto al ecosistema en general, Databricks tiene un fuerte enfoque en la comunidad de Apache Spark, mientras que Snowflake se orienta más hacia el almacenamiento de datos y el espacio de análisis. Dependiendo de las necesidades específicas de tu organización, una plataforma puede proporcionar un mejor soporte y recursos para tu caso de uso.

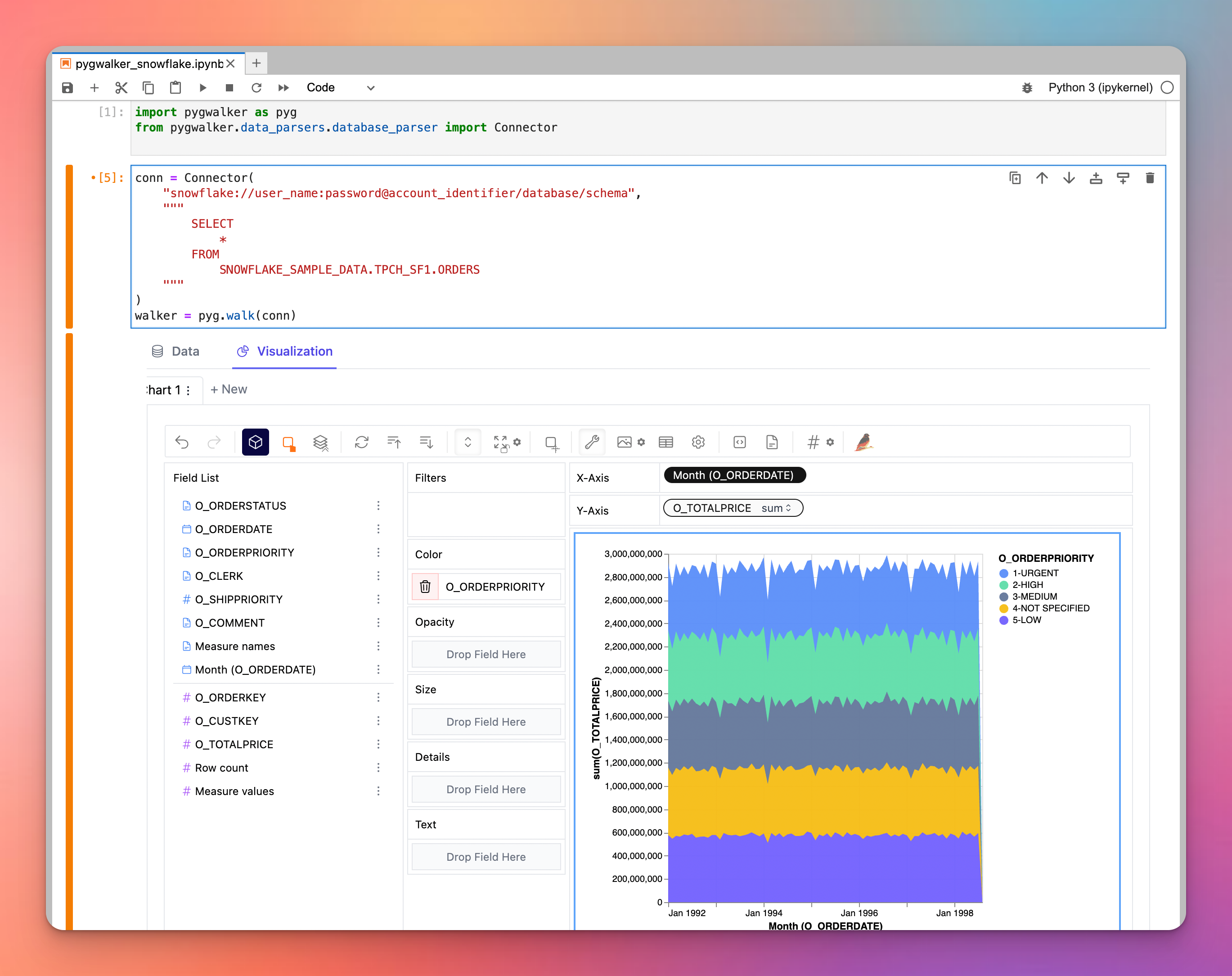

Por cierto, ¿qué tal intentar explorar visualmente tus datos en Snowflake/Databricks con PyGWalker?

Si estás buscando una potente herramienta de visualización, considera pygwalker, una innovadora biblioteca de Python que transforma los dataframes en una aplicación de visualización similar a Tableau. Es importante destacar que pygwalker puede delegar sus consultas en motores externos, como Snowflake. Esta sinergia permite a los usuarios aprovechar la potencia de cálculo de Snowflake mientras ofrecen visualizaciones impresionantes, básicamente conectando lo mejor de ambos mundos. Sumérgete en pygwalker para elevar el nivel de tus visualizaciones de datos. PyGWalker ahora se ha lanzado en Kanaries (opens in a new tab). Ahora puedes obtener un 50% de descuento en el primer mes de tu suscripción. Consulta la página principal de pygwalker (opens in a new tab) para obtener más detalles.

Conclusión

Databricks y Snowflake son dos plataformas potentes diseñadas para abordar diferentes aspectos del procesamiento y análisis de datos. Databricks brilla en el procesamiento de grandes volúmenes de datos, el aprendizaje automático y las cargas de trabajo de inteligencia artificial, mientras que Snowflake destaca en el almacenamiento de datos, almacenamiento y análisis. Para tomar la mejor decisión para tu organización, es crucial considerar tus requisitos específicos, presupuesto y necesidades de integración.