Databricks vs Snowflake: Uma Comparação Abrangente para Analistas e Cientistas de Dados

Updated on

À medida que os dados continuam a crescer em importância e complexidade, os analistas e cientistas de dados precisam aproveitar as ferramentas mais adequadas para obter insights valiosos. Nesta comparação abrangente, vamos explorar duas das plataformas de dados mais populares: Databricks e Snowflake. Vamos examinar suas características, benefícios e desvantagens para ajudá-lo a tomar uma decisão informada sobre a melhor ferramenta para suas necessidades. Além disso, incluiremos links internos relevantes para fornecer mais recursos e contexto.

Visão Geral

O Databricks (opens in a new tab) é uma plataforma em nuvem que fornece um espaço de trabalho unificado para análise de big data, aprendizado de máquina e aplicativos de IA. Ele é construído sobre a popular estrutura Apache Spark, permitindo que os usuários ampliem suas tarefas de processamento e análise de dados de forma eficiente.

O Snowflake (opens in a new tab), por outro lado, é uma solução de data warehouse em nuvem que se concentra no armazenamento, gerenciamento e análise de dados estruturados e semiestruturados. Ele foi projetado para suportar processamento paralelo em massa (MPP), que permite consultas e análises rápidas de dados.

Principais Características

Databricks

- Plataforma de Análise Unificada: O Databricks combina engenharia de dados, ciência de dados e capacidades de IA em uma única plataforma, permitindo a colaboração entre diferentes equipes e funções.

- Apache Spark: Como uma plataforma baseada no Spark, o Databricks oferece alto desempenho e escalabilidade para processamento de big data e cargas de trabalho de aprendizado de máquina.

- Espaço de Trabalho Interativo: O Databricks fornece um espaço de trabalho interativo com suporte para várias linguagens, incluindo Python, R, Scala e SQL. Ele também possui integração nativa com Jupyter Notebook (opens in a new tab).

- MLflow: O Databricks inclui o MLflow, uma plataforma de código aberto para gerenciar o ciclo de vida completo do aprendizado de máquina, simplificando o desenvolvimento e implantação de modelos.

- Delta Lake: O Delta Lake é uma camada de armazenamento de código aberto que oferece transações ACID e outras recursos de confiabilidade de dados ao seu data lake, melhorando a qualidade e consistência dos dados.

Snowflake

- Data Warehouse em Nuvem: O foco principal do Snowflake é fornecer uma solução de data warehouse em nuvem escalável e fácil de usar.

- Arquitetura Única: A arquitetura do Snowflake separa o armazenamento, o processamento e os serviços em nuvem, permitindo escalonamento e otimização independentes.

- Suporte para Dados Estruturados e Semiestruturados: O Snowflake pode lidar com dados estruturados e semiestruturados, como JSON, Avro, Parquet e XML.

- Compartilhamento e Integração de Dados: O Snowflake oferece recursos nativos de compartilhamento de dados, simplificando a colaboração de dados entre organizações. Ele também oferece uma ampla variedade de ferramentas de integração de dados (opens in a new tab) para simplificar a ingestão e processamento de dados.

- Segurança e Conformidade: O Snowflake tem um forte foco em segurança e conformidade, com recursos como criptografia, controle de acesso baseado em funções e suporte para diversos padrões de conformidade.

Comparando Desempenho, Escalabilidade e Custo

Desempenho

O Databricks, sendo baseado no Apache Spark, é otimizado para processamento de dados e tarefas de aprendizado de máquina de alto desempenho. Em comparação, o foco do Snowflake em data warehousing se traduz em consultas rápidas e análises. No entanto, quando se trata de cargas de trabalho de aprendizado de máquina e IA, o Databricks possui uma clara vantagem.

Escalabilidade

Tanto o Databricks quanto o Snowflake são projetados para escalar de acordo com as necessidades dos seus dados. O Databricks utiliza as capacidades do Spark para lidar com o processamento de big data, enquanto a arquitetura única do Snowflake permite dimensionar independentemente os recursos de armazenamento e processamento. Essa flexibilidade permite que as organizações ajustem sua infraestrutura com base em requisitos e restrições orçamentárias específicas.

Custo

O Databricks e o Snowflake oferecem modelos de precificação pay-as-you-go, o que significa que você paga apenas pelos recursos que consome. No entanto, suas estruturas de preços diferem em alguns aspectos importantes. O Databricks cobra com base em instâncias de máquinas virtuais, armazenamento de dados e transferência de dados, enquanto o preço do Snowflake é determinado pelo volume de dados armazenados, o número de recursos de processamento (também conhecidos como "warehouses") e a quantidade de dados ingestados.

É importante avaliar cuidadosamente as necessidades de processamento e armazenamento de dados da sua organização para determinar qual plataforma oferece a solução mais econômica. Tenha em mente que a otimização de custos muitas vezes depende da gestão eficiente de recursos e da utilização de recursos como auto-scaling e auto-pause.

Integração e Ecossistema

Tanto o Databricks quanto o Snowflake oferecem amplas opções de integração com fontes de dados, ferramentas e plataformas populares.

-

Databricks se integra perfeitamente a ferramentas de processamento de big data como o Hadoop, bem como serviços de armazenamento de dados como Amazon S3, Azure Blob Storage e Google Cloud Storage. Além disso, ele suporta ferramentas populares de visualização de dados como Tableau e Power BI.

-

Snowflake, sendo uma solução de data warehouse, oferece inúmeros conectores e opções de integração para ingestão de dados e processos de ETL, incluindo ferramentas populares como Fivetran, Matillion e Talend. Ele também suporta integração com plataformas de inteligência de negócios como Looker, Tableau e Power BI.

Quando se trata do ecossistema geral, o Databricks tem um forte foco na comunidade Apache Spark, enquanto o Snowflake está mais voltado para o espaço de data warehousing e análise. Dependendo das necessidades específicas da sua organização, uma plataforma pode oferecer um melhor suporte e recursos para o seu caso de uso.

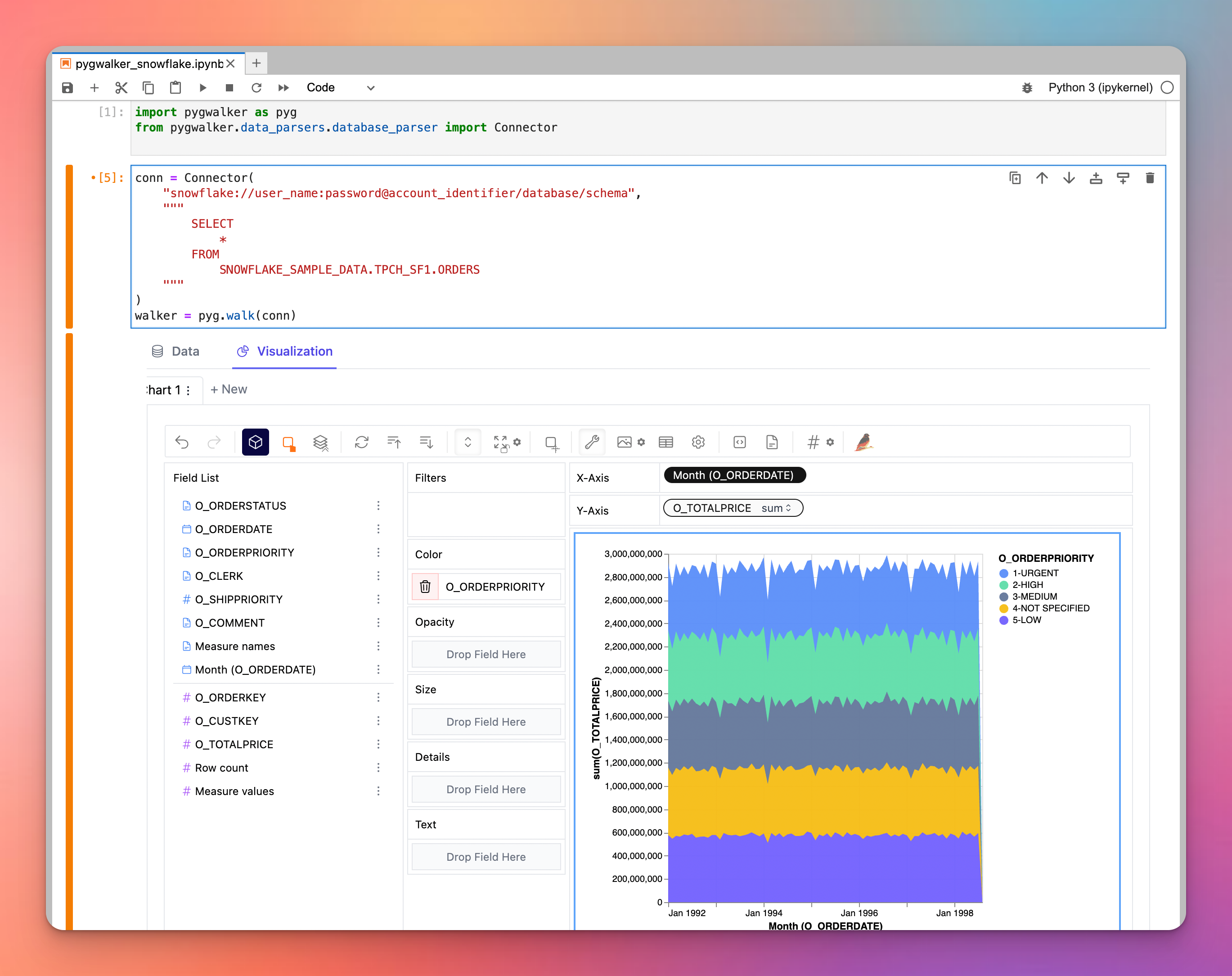

A propósito, que tal explorar visualmente seus dados no Snowflake / Databricks com o PyGWalker?

Se você está procurando uma ferramenta de visualização poderosa, considere o PyGWalker, uma biblioteca Python inovadora que transforma dataframes em uma aplicação de visualização semelhante ao Tableau. Notavelmente, o PyGWalker pode delegar suas consultas para mecanismos externos, como o Snowflake. Essa sinergia permite que os usuários aproveitem o poder computacional do Snowflake enquanto entregam visualizações de excelência, essencialmente unindo o melhor dos dois mundos. Explore o PyGWalker para elevar seu jogo de visualização de dados. O PyGWalker agora foi lançado na Kanaries (opens in a new tab). Agora você pode obter um desconto de 50% no primeiro mês de assinatura. Confira a página inicial do PyGWalker (opens in a new tab) para mais detalhes.

Conclusão

O Databricks e o Snowflake são duas plataformas poderosas projetadas para abordar diferentes aspectos do processamento e análise de dados. O Databricks se destaca no processamento de big data, aprendizado de máquina e cargas de trabalho de IA, enquanto o Snowflake se destaca em data warehousing, armazenamento e análise de dados. Para fazer a melhor escolha para sua organização, é crucial considerar seus requisitos específicos, orçamento e necessidades de integração.