Databricks vs Snowflake: Une Comparaison Complète pour les Analystes de Données et les Data Scientists

Updated on

À mesure que les données continuent de gagner en importance et en complexité, les analystes de données et les data scientists doivent tirer parti des outils les plus adaptés pour obtenir des informations précieuses. Dans cette comparaison complète, nous explorerons deux des plates-formes de données les plus populaires : Databricks et Snowflake. Nous examinerons leurs fonctionnalités, leurs avantages et leurs inconvénients afin de vous aider à prendre une décision éclairée quant à l'outil adapté à vos besoins. De plus, nous inclurons des liens internes pertinents pour fournir des ressources supplémentaires et du contexte.

Aperçu

Databricks (opens in a new tab) est une plate-forme basée sur le cloud qui offre un espace de travail analytique unifié pour le traitement des mégadonnées, l'apprentissage automatique et les applications d'intelligence artificielle. Elle est construite sur le populaire framework Apache Spark, ce qui permet aux utilisateurs de mettre à l'échelle efficacement leurs tâches de traitement et d'analyse des données.

Snowflake (opens in a new tab), en revanche, est une solution d'entrepôt de données basée sur le cloud qui se concentre sur le stockage, la gestion et l'analyse des données structurées et semi-structurées. Elle est conçue pour prendre en charge le traitement massivement parallèle (MPP), ce qui permet une interrogation et une analyse rapides des données.

Caractéristiques clés

Databricks

- Plate-forme analytique unifiée: Databricks combine les capacités d'ingénierie des données, de science des données et d'intelligence artificielle dans une même plate-forme, favorisant la collaboration entre différentes équipes et rôles.

- Apache Spark: En tant que plate-forme basée sur Spark, Databricks offre des performances élevées et une capacité de mise à l'échelle pour le traitement des mégadonnées et les charges de travail d'apprentissage automatique.

- Espace de travail interactif: Databricks propose un espace de travail interactif avec prise en charge de différents langages, notamment Python, R, Scala et SQL. Il intègre également Jupyter Notebook (opens in a new tab).

- MLflow: Databricks inclut MLflow, une plate-forme open source pour la gestion du cycle de vie complet de l'apprentissage automatique, simplifiant ainsi le développement et le déploiement des modèles.

- Delta Lake: Delta Lake est une couche de stockage open source qui apporte des transactions ACID et d'autres fonctionnalités de fiabilité des données à votre Data Lake, améliorant ainsi la qualité et la cohérence des données.

Snowflake

- Entrepôt de données dans le cloud: Snowflake se concentre principalement sur la fourniture d'une solution d'entrepôt de données évolutive et facile à utiliser basée sur le cloud.

- Architecture unique: L'architecture de Snowflake sépare le stockage, le calcul et les services cloud, ce qui permet une mise à l'échelle indépendante et une optimisation des coûts.

- Prise en charge des données structurées et semi-structurées: Snowflake peut gérer à la fois des données structurées et semi-structurées, telles que JSON, Avro, Parquet et XML.

- Partage et intégration des données: Snowflake offre des capacités natives de partage des données, simplifiant la collaboration des données entre les organisations. Elle propose également une large gamme d'outils d'intégration de données (opens in a new tab) pour rationaliser l'ingestion et le traitement des données.

- Sécurité et conformité: Snowflake accorde une grande importance à la sécurité et à la conformité, avec des fonctionnalités telles que le chiffrement, le contrôle d'accès basé sur les rôles et la prise en charge de différentes normes de conformité.

Comparaison des performances, de la mise à l'échelle et des coûts

Performances

Databricks, étant construit sur Apache Spark, est optimisé pour le traitement des données à haute performance et les tâches d'apprentissage automatique. En comparaison, l'accent de Snowflake sur l'entreposage des données se traduit par une exécution rapide des requêtes et des analyses. Cependant, en ce qui concerne les charges de travail d'apprentissage automatique et d'intelligence artificielle, Databricks a un avantage clair.

Mise à l'échelle

Databricks et Snowflake sont tous deux conçus pour évoluer en fonction de vos besoins en matière de données. Databricks tire parti des capacités de Spark pour gérer le traitement des mégadonnées, tandis que l'architecture unique de Snowflake permet une mise à l'échelle indépendante des ressources de stockage et de calcul. Cette flexibilité permet aux organisations d'adapter leur infrastructure en fonction de leurs besoins spécifiques et de leurs contraintes budgétaires.

Coûts

Databricks et Snowflake proposent des modèles tarifaires à la consommation, ce qui signifie que vous ne payez que pour les ressources que vous consommez. Cependant, leurs structures tarifaires diffèrent sur certains points clés. Databricks facture en fonction des instances de machines virtuelles, du stockage des données et du transfert des données, tandis que le prix de Snowflake est déterminé par le volume des données stockées, le nombre de ressources de calcul (également appelées "entrepôts") et la quantité de données ingérées.

Il est important d'évaluer attentivement les besoins de traitement et de stockage des données de votre organisation afin de déterminer quelle plate-forme offre la solution la plus rentable. Gardez à l'esprit que l'optimisation des coûts dépend souvent d'une gestion efficace des ressources et de l'utilisation de fonctionnalités telles que l'auto-mise à l'échelle et la mise en pause automatique.

Intégration et écosystème

Databricks et Snowflake offrent tous deux de nombreuses options d'intégration avec des sources de données, des outils et des plates-formes populaires.

-

Databricks s'intègre parfaitement avec des outils de traitement des mégadonnées tels que Hadoop, ainsi qu'avec des services de stockage des données tels qu'Amazon S3, Azure Blob Storage et Google Cloud Storage. De plus, il prend en charge des outils de visualisation des données populaires tels que Tableau et Power BI.

-

Snowflake, en tant que solution d'entrepôt de données, propose de nombreux connecteurs et options d'intégration pour l'ingestion et les processus ETL des données, y compris des outils populaires tels que Fivetran, Matillion et Talend. Elle prend également en charge l'intégration avec des plateformes de business intelligence telles que Looker, Tableau et Power BI.

En ce qui concerne l'écosystème global, Databricks se concentre fortement sur la communauté Apache Spark, tandis que Snowflake est davantage axé sur le domaine de l'entreposage et de l'analyse des données. Selon les besoins spécifiques de votre organisation, une plate-forme peut offrir un meilleur support et des ressources plus adaptées à votre cas d'utilisation.

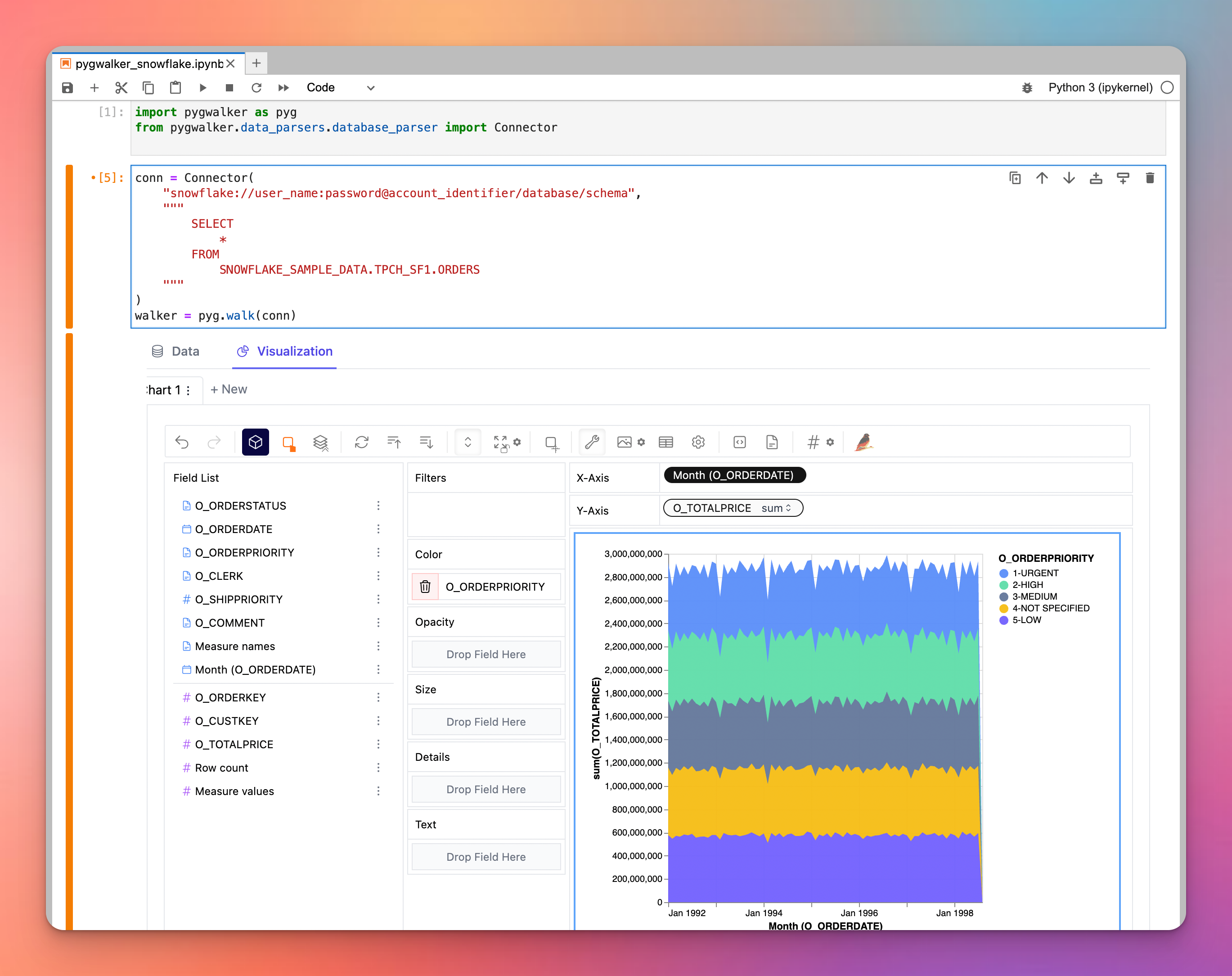

Au fait, que diriez-vous d'explorer visuellement vos données dans Snowflake/Databricks avec PyGWalker ?

Si vous êtes à la recherche d'un outil de visualisation puissant, envisagez d'utiliser PyGWalker, une bibliothèque Python révolutionnaire qui transforme les dataframes en une application de visualisation similaire à Tableau. Notamment, PyGWalker peut déléguer ses requêtes à des moteurs externes, tels que Snowflake. Cette synergie permet aux utilisateurs de tirer parti de la puissance de calcul de Snowflake tout en offrant des visualisations exceptionnelles, combinant essentiellement le meilleur des deux mondes. Plongez dans PyGWalker pour élever votre jeu de visualisation des données. PyGWalker est maintenant lancé sur Kanaries (opens in a new tab). Vous pouvez maintenant bénéficier d'une réduction de 50 % sur le premier mois de votre abonnement. Consultez la page d'accueil de PyGWalker (opens in a new tab) pour plus de détails.

Conclusion

Databricks et Snowflake sont deux plates-formes puissantes conçues pour répondre à différents aspects du traitement et de l'analyse des données. Databricks brille dans le traitement des mégadonnées, les charges de travail d'apprentissage automatique et d'intelligence artificielle, tandis que Snowflake excelle dans l'entreposage des données, le stockage et l'analyse. Pour faire le meilleur choix pour votre organisation, il est essentiel de prendre en compte vos besoins spécifiques, votre budget et vos besoins d'intégration.