Databricks vs. Snowflake: Ein umfassender Vergleich für Datenanalysten und Datenwissenschaftler

Updated on

Da Daten immer wichtiger und komplexer werden, müssen Datenanalysten und Datenwissenschaftler die am besten geeigneten Tools nutzen, um wertvolle Erkenntnisse zu gewinnen. In diesem umfassenden Vergleich werden wir zwei der beliebtesten Datenplattformen untersuchen: Databricks und Snowflake. Wir werden ihre Funktionen, Vorteile und Nachteile untersuchen, um Ihnen bei der Entscheidung für das richtige Tool zu helfen. Darüber hinaus werden wir relevante interne Links einfügen, um weitere Ressourcen und Kontext zu liefern.

Übersicht

Databricks (opens in a new tab) ist eine cloudbasierte Plattform, die eine gemeinsame Analyseumgebung für die Verarbeitung großer Datenmengen, maschinelles Lernen und KI-Anwendungen bietet. Sie basiert auf dem beliebten Apache Spark-Framework und ermöglicht es den Benutzern, ihre Datenverarbeitungs- und Analyseaufgaben effizient zu skalieren.

Snowflake (opens in a new tab) hingegen ist eine cloudbasierte Data-Warehouse-Lösung, die sich auf die Speicherung, Verwaltung und Analyse strukturierter und halbstrukturierter Daten konzentriert. Sie ist darauf ausgelegt, massiv parallele Verarbeitung (MPP) zu unterstützen, was schnelle Abfragen und Analysen der Daten ermöglicht.

Wesentliche Funktionen

Databricks

- Unified Analytics Platform: Databricks kombiniert Funktionen für Datenengineering, Datenwissenschaft und KI in einer Plattform und ermöglicht so die Zusammenarbeit zwischen verschiedenen Teams und Rollen.

- Apache Spark: Als eine auf Spark basierende Plattform bietet Databricks eine hohe Leistung und Skalierbarkeit für die Verarbeitung großer Datenmengen und maschinelles Lernen.

- Interaktiver Arbeitsbereich: Databricks bietet einen interaktiven Arbeitsbereich mit Unterstützung für verschiedene Sprachen, darunter Python, R, Scala und SQL. Es verfügt auch über eine integrierte Jupyter Notebook (opens in a new tab)-Integration.

- MLflow: Databricks enthält MLflow, eine Open-Source-Plattform zum Management des gesamten Machine-Learning-Lebenszyklus, die die Entwicklung und Bereitstellung von Modellen vereinfacht.

- Delta Lake: Delta Lake ist eine Open-Source-Speicherschicht, die ACID-Transaktionen und andere Funktionen zur Gewährleistung der Datenzuverlässigkeit in Ihrem Data Lake bietet und so die Datenqualität und -konsistenz verbessert.

Snowflake

- Cloud Data Warehouse: Snowflakes Hauptaugenmerk liegt auf der Bereitstellung einer skalierbaren und benutzerfreundlichen cloudbasierten Data-Warehouse-Lösung.

- Einzigartige Architektur: Snowflakes Architektur trennt Speicherung, Rechenleistung und Cloud-Services voneinander, was unabhängiges Skalieren und Kostenoptimierung ermöglicht.

- Unterstützung für strukturierte und halbstrukturierte Daten: Snowflake kann sowohl strukturierte als auch halbstrukturierte Daten wie JSON, Avro, Parquet und XML verarbeiten.

- Datenfreigabe und Integration: Snowflake bietet native Funktionen zur Datenfreigabe, die die Zusammenarbeit zwischen Organisationen vereinfachen. Es bietet auch eine Vielzahl von Datenintegrationswerkzeugen (opens in a new tab), um die Dateninjektion und -verarbeitung zu optimieren.

- Sicherheit und Compliance: Snowflake legt großen Wert auf Sicherheit und Compliance und bietet Funktionen wie Verschlüsselung, rollenbasierte Zugriffskontrolle und Unterstützung für verschiedene Compliance-Standards.

Vergleich von Leistung, Skalierbarkeit und Kosten

Leistung

Databricks, das auf Apache Spark basiert, ist optimiert für die Hochleistungsverarbeitung von Daten und maschinellem Lernen. Im Vergleich dazu liegt Snowflakes Fokus auf Data Warehousing und führt zu schneller Abfrageausführung und Analyse. Bei maschinellem Lernen und KI-Aufgaben hat Databricks jedoch einen klaren Vorteil.

Skalierbarkeit

Sowohl Databricks als auch Snowflake sind entwickelt worden, um sich mit Ihren Datenanforderungen skalieren zu können. Databricks nutzt Spark's Fähigkeiten zur Verarbeitung großer Datenmengen, während Snowflakes einzigartige Architektur eine unabhängige Skalierung von Speicher- und Rechenressourcen ermöglicht. Diese Flexibilität ermöglicht es Organisationen, ihre Infrastruktur basierend auf ihren spezifischen Anforderungen und Budgetbeschränkungen anzupassen.

Kosten

Databricks und Snowflake bieten Preismodelle auf Basis von Pay-as-you-go an, d.h. Sie zahlen nur für die Ressourcen, die Sie verbrauchen. Ihre Preisstrukturen unterscheiden sich jedoch in einigen wesentlichen Aspekten. Databricks berechnet die Kosten basierend auf virtuellen Maschinen, Datenspeicherung und Datentransfer, während Snowflakes Preisgestaltung durch das Volumen der gespeicherten Daten, die Anzahl der Compute-Ressourcen (auch als "Warehouses" bezeichnet) und die Menge der injizierten Daten bestimmt wird.

Es ist wichtig, die Datenverarbeitungs- und Speicherbedürfnisse Ihrer Organisation sorgfältig zu bewerten, um festzustellen, welche Plattform die kostengünstigste Lösung bietet. Beachten Sie, dass die Kostenoptimierung oft von einer effizienten Ressourcenverwaltung und der Nutzung von Funktionen wie Auto-Scaling und Auto-Pause abhängt.

Integration und Ökosystem

Sowohl Databricks als auch Snowflake bieten umfangreiche Integrationsoptionen mit beliebten Datenquellen, Tools und Plattformen.

-

Databricks integriert sich nahtlos mit Big Data-Verarbeitungstools wie Hadoop sowie mit Datenspeicherdiensten wie Amazon S3, Azure Blob Storage und Google Cloud Storage. Zudem unterstützt es beliebte Data-Visualisierungstools wie Tableau und Power BI.

-

Snowflake bietet als Data-Warehouse-Lösung zahlreiche Connectors und Integrationsoptionen für Dateninjektion und ETL-Prozesse, einschließlich beliebter Tools wie Fivetran, Matillion und Talend. Es unterstützt auch die Integration mit Business-Intelligence-Plattformen wie Looker, Tableau und Power BI.

In Bezug auf das Gesamtsystem liegt der Schwerpunkt von Databricks auf der Apache Spark-Community, während Snowflake sich mehr auf das Data Warehousing und die Analyse konzentriert. Abhängig von den spezifischen Anforderungen Ihrer Organisation kann eine Plattform möglicherweise bessere Unterstützung und Ressourcen für Ihren Anwendungsfall bieten.

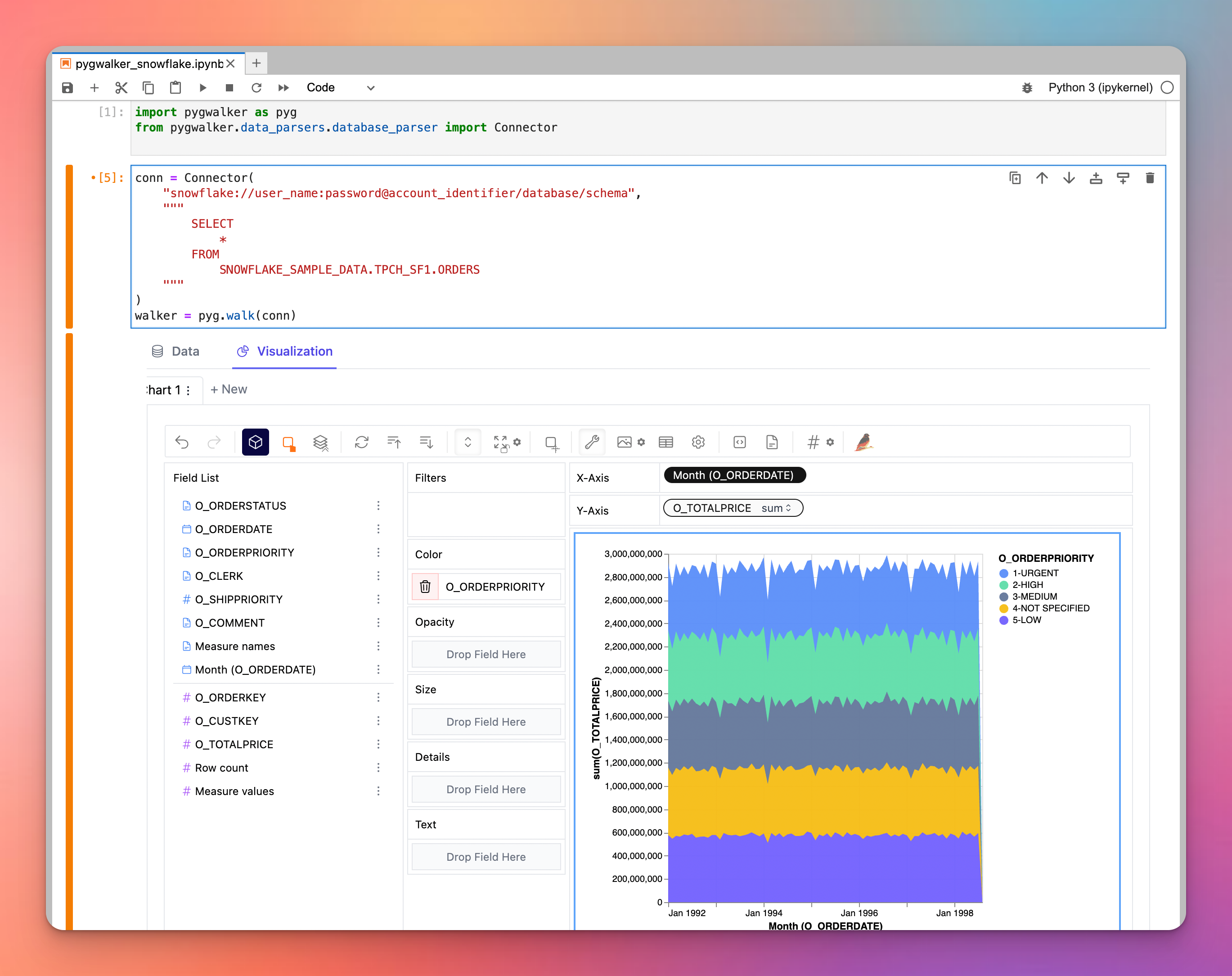

Übrigens, wie wäre es, Ihre Daten in Snowflake/Databricks mit PyGWalker visuell zu erkunden?

Wenn Sie nach einem leistungsstarken Visualisierungstool suchen, sollten Sie PyGWalker in Betracht ziehen - eine bahnbrechende Python-Bibliothek, die Dataframes in eine Tableau-ähnliche Visualisierungsanwendung verwandelt. Insbesondere kann PyGWalker seine Abfragen an externe Engines wie Snowflake delegieren. Diese Synergie ermöglicht es Benutzern, die Rechenleistung von Snowflake zu nutzen und gleichzeitig beeindruckende Visualisierungen zu erstellen, was im Wesentlichen das Beste aus beiden Welten vereint. Tauchen Sie ein in PyGWalker, um Ihr Datenvisualisierungsspiel auf ein neues Niveau zu heben. PyGWalker ist jetzt auf Kanaries (opens in a new tab) gestartet. Sie erhalten jetzt einen 50%igen Rabatt auf den ersten Monat Ihres Abonnements. Besuchen Sie die Homepage von PyGWalker (opens in a new tab) für weitere Details.

Fazit

Databricks und Snowflake sind beide leistungsstarke Plattformen, die verschiedene Aspekte der Datenverarbeitung und -analyse abdecken. Databricks glänzt bei der Verarbeitung großer Datenmengen, maschinellem Lernen und KI-Aufgaben, während Snowflake bei Data Warehousing, Speicherung und Analyse herausragt. Um die beste Wahl für Ihre Organisation zu treffen, ist es wichtig, Ihre spezifischen Anforderungen, Ihr Budget und Ihre Integrationsbedürfnisse zu berücksichtigen.