ChatGPT-4Oの発表: 会話型AIの量子飛躍

Updated on

OpenAIはChatGPT-4Oの発表により、人工知能の可能性の限界を再び押し広げました。この最新のAIモデルは、技術とのインタラクションの方法を革命的に変える画期的な機能を導入しています。これらのエキサイティングなアップデートを詳しく見て、どのように私たちに利益をもたらし、革新的な応用を促進するかを探ってみましょう。

1. リアルタイム音声コミュニケーション

ChatGPT-4Oの最も重要な進歩の一つは、リアルタイムの音声コミュニケーション機能です。以前のバージョンでは音声処理に短い一時停止が必要でしたが、ChatGPT-4Oは瞬時に応答します。この改善により、AIとの会話はより自然で流暢に感じられ、ユーザーエクスペリエンスが向上します。

利点と応用:

- 顧客サービスの強化: 企業はリアルタイムの音声アシスタントを導入することで、即時サポートを提供し、待ち時間を削減し、顧客満足度を向上させることができます。

- インタラクティブな学習: 教育プラットフォームは、リアルタイムのチュータリングセッションを提供し、学習をより魅力的で生徒のニーズに応えるものにします。

- ハンズフリーアシスタンス: リアルタイムの音声コミュニケーションにより、運転中やプロフェッショナルな環境で複雑なタスクを行う際に、より効果的なハンズフリー操作が可能になります。

2. AI音声の感情ニュアンス

ChatGPT-4Oの音声は、より多くの感情的な深みを持ち、より共感的で人間らしい対話を可能にします。この発展は、AIとのコミュニケーションをより意味深く効果的にするために重要です。

利点と応用:

- メンタルヘルスサポート: AI駆動のメンタルヘルスアプリは、より共感的な応答を提供し、より良い感情的なサポートとつながりを提供します。

- エンターテインメントとストーリーテリング: AIはオーディオブック、ゲーム、インタラクティブな物語でキャラクターをより表現力豊かで魅力的な声で生き生きとさせます。

- パーソナルアシスタント: バーチャルアシスタントは、より個人的で感情に寄り添った応答を提供し、ユーザー満足度とインタラクションの質を向上させます。

3. リアルタイム視覚能力

ChatGPT-4Oの新しいリアルタイム視覚能力により、視覚的な入力を見て理解することができ、視覚と音声の出力をシームレスに統合するエンドツーエンドの能力を提供します。

利点と応用:

- 拡張現実(AR): リアルタイムの視覚と音声のフィードバックを活用して、AR体験をよりインタラクティブかつ情報豊かにします。

- 医療: リアルタイムの視覚分析により、X線やMRIスキャンなどの視覚データに基づいた即時の洞察を提供し、医療診断をサポートします。

- アクセシビリティ: 視覚障害者に周囲の説明やリアルタイムでのテキストや標識の読み上げを提供します。

4. 視覚を通じたコード読み取り

ChatGPT-4Oは視覚的な入力を通じてコードを読み理解することができ、OCR(光学文字認識)モデルを必要としません。この機能により、手書きや画面に表示されたコードの作業が効率化されます。

利点と応用:

- ソフトウェア開発: 開発者はコードをAIに見せるだけで、デバッグや分析を迅速に行い、開発プロセスをスピードアップできます。

- 教育: コーディングブートキャンプやチュートリアルは、この機能を活用して、生徒の手書きコードに即座にフィードバックを提供できます。

- ドキュメンテーション: 教科書やスクリーンショットからのコードスニペットの解釈を容易かつ迅速に行い、学習や参照を支援します。

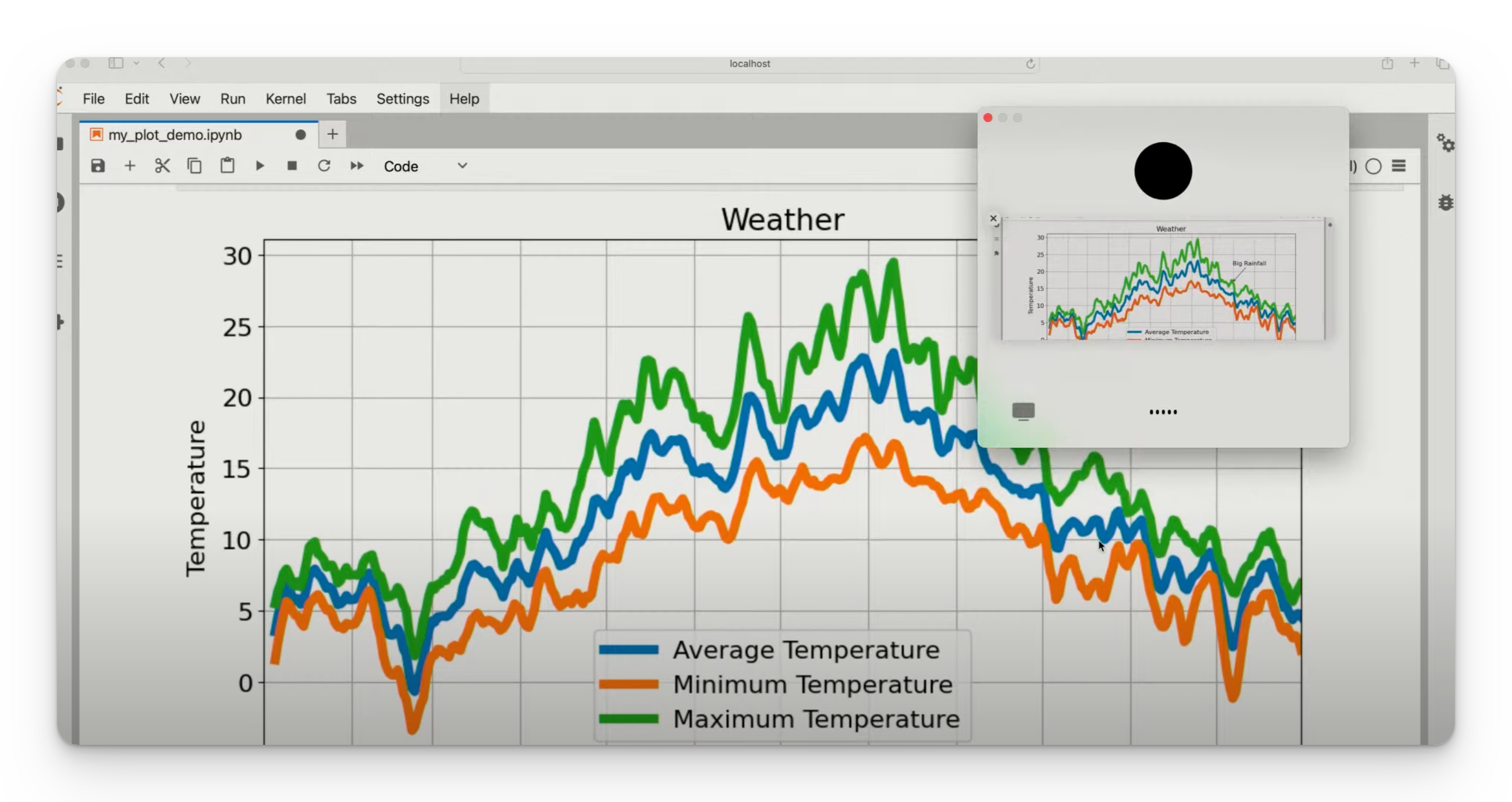

5. データおよびチャートの読み取り

強化された視覚能力を持つChatGPT-4Oは、チャートやデータビジュアライゼーションを読み取り解釈することができます。この能力により、データとのインタラクションがよりアクセスしやすく、実践的なものとなります。

利点と応用:

- ビジネスインテリジェンス: 会議中にリアルタイムでチャートやデータの分析を行い、意思決定プロセスを支援します。

- 教育: 教師はAIを活用して、生徒が複雑なデータビジュアライゼーションを理解するのを支援し、学習をよりインタラクティブで効果的なものにします。

- 研究: 研究者はチャートやグラフからデータを迅速に解釈し、分析プロセスを効率化し、生産性を向上させます。

この機能がデータ分析にどのように影響を与えるのか試してみたい? 今すぐ Data Visualization (opens in a new tab) で gpt4o によって 強化されたエージェ���トを活用して、Kanaries AI Analytic をチェックしてください。

6. 翻訳能力の向上

ChatGPT-4Oは、大幅に向上した翻訳能力を誇り、異なる言語間のコミュニケーションをよりスムーズで正確にします。

利点と応用:

- グローバルコラボレーション: 企業やチームが言語の壁を超えてより効果的にコミュニケーションを取り、国際的なコラボレーションを促進します。

- 旅行と観光: 観光客は正確かつリアルタイムな標識、メニュー、会話の翻訳により、海外旅行を容易にナビゲートできます。

- 教育: 言語学習アプリは、より正確な翻訳と文脈を提供し、生徒の学習体験を強化します。

GPT-4O API

OpenAIは今回、GPT-4OのAPIもリリースしまし��。以下は、GPT-4OとGPT-4 Turboの違いです。

| Feature | Description |

|---|---|

| High intelligence | GPT-4 Turboレベルのテキスト、推論、およびコーディングの知能を持ち、多言語、音声、視覚能力で新たな高水準を達成。 |

| 2x faster | GPT-4Oは、トークンの生成速度がGPT-4 Turboの2倍。 |

| 50% cheaper pricing | GPT-4Oは、GPT-4 Turboより50%安価で、入力トークンあたり$5、出力トークンあたり$15のコスト。 |

| 5x higher rate limits | GPT-4Oは、GPT-4 Turboの5倍のレートリミットを持ち、最大毎分10百万トークン。高使用量の開発者向けに今後数週間でこのレベルまでレートリミットが引き上げられます。 |

| Improved vision | GPT-4Oは、大半のタスクで視覚能力が向上。 |

| Improved non-English language capabilities | GPT-4Oは、新しいトークナイザーを使用して、非英語テキストのトークン化をより効率的に行い、非英語言語の能力が向上。 |

| Context window and knowledge cut-off | GPT-4Oは、128Kのコンテキストウィンドウを持ち、知識のカットオフ日が2023年10月。 |

| Video understanding in API | GPT-4Oは、ビデオ(オーディオなし)の理解をビジョン機能でサポートし、ビデオをフレーム(毎秒2〜4フレーム)に変換して入力。 |

| Audio support in API | GPT-4Oは、APIでのオーディオサポートはまだ提供していませんが、今後数週間で信頼できるテスター向けにこのモダリティが提供される予定。 |

| Image generation support in API | GPT-4Oは、APIでの画像生成をサポートしていません。画像生成にはDALL-E 3 APIがおすすめです。 |

| Recommendation for users | GPT-4またはGPT-4 TurboのユーザーにはGPT-4Oへの切り替えを評価することを推奨。ビジョンとモデル間の出力比較をサポートするAPIドキュメントとプレイグラウンドを利用可能。 |

この表は、GPT-4Oの主要な機能と改善点を要約しており、視覚や多言語サポートにおける性能、コスト効率、および能力の向上を強調しています。

結論

ChatGPT-4Oの発表は、会話型AIの進化において画期的な一歩を踏み出しています。リアルタイムの音声コミュニケーション、感情のニュアンス、リアルタイムの視覚能力、視覚を通じたコード読み取り、データおよびチャートの解釈、翻訳能力の向上など、その応用例は広範で変革的です。これらの高度なAI能力を日常生活に統合し続けることで、生産性、アクセシビリティ、および人間とAIの相互作用の全体的な質の向上が期待されます。未来はすでにここにあり、これまで以上に知的でインタラクティブになっています。